Índice

2.Posibles formas en que nuestro Universo (el de la materia

ordinaria) puede “pedir ayuda” al Universo del vacío cuántico

3.Explicación

alternativa del experimento de la doble rendija

4.Explicación

alternativa a la Fusión Nuclear

5.Explicación

alternativa a la Electrodinámica Cuántica

6.Visión

sobre los agujeros de gusano de Einstein-Rosen

7.Visión

sobre los infinitos mundos de Everett

8.Implicaciones

acerca de la Teoría de Cuerdas y Supersimetría

9.Visión

sobre el Big Bang de Julian Barbour y el entrelazamiento cuántico

10.Visión

sobre el Megauniverso que respeta la simetría CPT

11.Big Bang

a partir de un agujero negro creado en un Universo anterior, agujero negro que

respeta que resuelve la llamada “Paradoja de la Información”, mediante el

“Principio Holográfico”

12.Visión

sobre Superconductividad y Pares de Cooper

13.Reversión

del estado de un fotón (experimento hecho en la Universidad de Austria)

14.Acción

conjunta energía oscura – materia oscura del Antiuniverso para provocar

distorsiones del espacio – tiempo en nuestro Universo. Aplicación de la

Conjetura Maldacena

15.Fusión

nuclear artificial vs fusión solar y tunelaje cuántico

16.Alternativa

a la nucleogénesis aceptada del Big Bang

17.Explicación

de la levitación

18.Explicación

alternativa a cómo sacar energía del vacío

19.Resonancia

Magnética, entrelazamiento y estado de consciencia en nuestro cerebro

20.Viajes al

pasado

21.Los

agujeros negros crecen no solamente por la materia que absorben, sino sobre

todo por la energía oscura del vacío

ANEXOS

Anexo 1.

Ecuación de onda de Schroedinger, aplicada al caso de un túnel cuántico

Anexo 2.

Dualidad onda-partícula, Postulado de Louis de Broglie y longitudes de onda de

un electrón y una pelota de beisbol

Anexo 3.

Principio de incertidumbre de Heisenberg para la energía-tiempo

Anexo 4.

Experimento de la doble rendija

Anexo 5.

Integral de caminos de Feynman

Anexo 6.

Tipos de partículas virtuales

Anexo 7.

Gravedad cuántica de bucles

Anexo 8.

Energía del vacío. La mayor discordancia de la historia de la ciencia

Anexo 9.

Ecuación de la Relatividad General de Einstein

Anexo 10.

Ecuación de Dirac

Anexo 11.

Métrica de Alcubierre

Anexo 12.

Pasos clave de la evolución

Anexo 13. La

mecánica cuántica en procesos biológicos

Anexo 14.

Tunelaje cuántico para conseguir la fusión nuclear en el Sol

Anexo 15.

¿Es nuestra consciencia cuántica?

Anexo 16.

Teoría de Cuerdas y Supersimetría

Anexo 17.

Agujeros negros primordiales, MACHOs y WIMMPs

Anexo 18.

Conjetura de Maldacena / Correspondencia AdS/CFT: Equivalencia

entre una teoría de cuerdas o una supergravedad definida en una

cierta clase de espacio anti-de Sitter y una teoría conforme de campos definida en su frontera con dimensión

menor por uno.

Anexo 19. Un

fotón ha retrocedido en el tiempo

Anexo 20.

Modelo Cosmológico del Big Bang Lambda-CDM (Cold Dark Matter)

1.

Resumen: El entrelazamiento cuántico, explicado a través de un planteamiento que

integra la Métrica de Alcubierre, la Conjetura de Maldacena y el Universo de

Barbour

Punto

de partida: unas cuantas ecuaciones clave

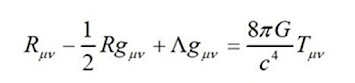

Ecuaciones

de campo de la Relatividad General de Einstein:

La materia le dice al espacio cómo curvarse, el espacio le

dice a la materia cómo moverse (John Wheeler)

Ecuación de onda de Schroedinger para una partícula libre:

En estado de entrelazamiento entre dos partículas, cuando una de ellas cambia a un estado definido, la otra instantáneamente cambia al estado complementario

El cambio es instantáneo, aunque ambas partículas se

encuentren a miles de años luz de distancia

Principio de Indeterminación de Heisenberg:

Esta permitido sacar grandes cantidades de energía del vacío si se hace durante tiempos infinitesimales, sin violar este principio

Ecuación

de Dirac:

Es la versión de la ecuación de onda de Schroedinger que tiene en cuenta los efectos relativistas

Predice la existencia de antimateria

Integral de caminos de Feynman:

https://naukas.com/2018/06/13/ultimo-articulo-hawking-la-naukas-iii-propuesta-ausencia-frontera/

Afirma que nuestra realidad es la suma de todas las realidades

posibles

Mi visión

Esa comunicación instantánea que se produce cuando dos

partículas están entrelazadas solo puede ser posible porque “algo” está

distorsionando enormemente el espacio-tiempo

Alcubierre encontró unas soluciones de la Teoría de la

Relatividad que, mediante enormes distorsiones del espacio-tiempo, permiten

viajar CON el espacio, No a través del espacio, sin violar el límite máximo de

velocidad permitido, la velocidad de la luz

Para mí, la conclusión fundamental de este documento es la

siguiente: a través de la Métrica de Alcubierre, sacando la enorme cantidad de

energía negativa que necesitamos del vacío, curvamos el espacio – tiempo lo

suficiente como para que se produzca la acción instantánea que tiene lugar

entre partículas entrelazadas que se encuentran separadas distancias enormes

Sacamos esas grandes cantidades de energía del vacío (son

energías y masas negativas) durante tiempos infinitesimales, lo que nos permite

no violar el Principio de Incertidumbre de Heisenberg

Las energías que, en la métrica de Alcubierre, necesitamos

sacar del vacío para viajar NO por el espacio sino CON el espacio:

Densidad de energía necesaria para llegar a la Métrica de Alcubierre:

Esta densidad de energía, sacada directamente de las

ecuaciones de la Relatividad General, es negativa y se requiere por tanto de

“materia exótica” para provocar las deformaciones del espacio – tiempo buscadas

En resumen, el entrelazamiento cuántico lo producimos

sacando del vacío la densidad de energía negativa que necesita la Métrica de

Alcubierre

Cuando se necesita transmitir algo al resto de partículas

entrelazadas, se acude a la energía de Alcubierre del vacío en el Universo

oscuro, lo que provoca una gran deformación del espacio-tiempo en nuestro

Universo, permitiendo la transmisión instantánea de información entre las

partículas entrelazadas, independientemente de la distancia que exista entre

ellas

La energía que sacamos del vacío es “energía oscura”

Esta energía que sacamos del vacío crea una enorme gravedad,

pero de signo de repulsión

El vacío ha creado una repulsión gravitatoria

Esta gravedad ha creado una deformación enorme del espacio –

tiempo, según las ecuaciones de Einstein

En estado de entrelazamiento cuántico entramos en las

condiciones de la Métrica de Alcubierre:

-Hay posibilidad

de pasos instantáneos en el espacio (sin violar la velocidad de la luz como

límite universal)

-Hay

posibilidades de atravesar las barreras de potencial de los túneles cuánticos

La siguiente pregunta es: ¿cómo es ese mundo del vacío, que

contiene esa energía antigravitatoria?

Mi visión es que estamos ante un agujero negro que ha sido

creado por colapso de un Universo anterior

Pero NO es un agujero negro infinitesimal, sino que obedece

a las reglas de la Teoría de la Gravedad Cuántica de Bucles y, por tanto, tiene

radio finito

¿Qué otras cualidades tendría ese agujero negro predecesor

de nuestro Universo?

Lo primero, creo que sería más preciso si llamamos a ese

agujero negro “el Universo anterior” a nuestro Big Bang

Otra posibilidad sería que ese “Universo oscuro” haya sido

creado en los instantes inmediatamente anteriores al Big Bang del Universo de

partículas que conocemos (eso supondría que realmente hubo dos Big Bangs, uno

de ese Universo oscuro y otro el de la materia ordinaria que conocemos)

En cualquier caso, la idea de un Big Crunch de un Universo

anterior tiene connotaciones muy atractivas:

-Siguiendo la

teoría de Julian Barbour, en ese Universo anterior el tiempo puede haber ido

hacia atrás

-Estamos hablando

de conceptos de tiempo termodinámico, o sea el relacionado con la entropía

-Según Julian

Barbour, en un Universo donde el tiempo corra hacia atrás, la entropía (o sea

el desorden) disminuye y, por tanto, la complejidad aumenta

-En ese Universo

paralelo de Julian Barbour, la dirección del tiempo está dominada por la

gravedad, no por la termodinámica

-En resumen, ese

Universo anterior a nuestro Big Bang habría llegado hacia fases / estados de

gran complejidad

Por otro lado, nos dice la Mecánica Cuántica que la

información (o sea los estados cuánticos) no puede desaparecer

Sabemos, por la Teoría Holográfica, que la información que

hay dentro de un agujero negro puede verse reflejada en el horizonte de sucesos

(recordemos que estamos hablando de un agujero negro de radio finito, NO

infinitesimal por tanto)

En suma, estaríamos ante un agujero negro que contiene toda

la información cuántica del Universo anterior

En resumen, siguiendo a Barbour, sería un Universo espejo al

nuestro, donde el tiempo termodinámico iba hacia atrás, la complejidad llegó a

niveles máximos y la información de todo lo que le ocurrió está grabada en su

horizonte de sucesos

¿De qué puede estar formado este Universo anterior?: la

antimateria sería una buena candidata, lo que permitiría cumplir la simetría

CPT

Partículas candidatas que existen en ese Universo: las

partículas SUSY de la Supersimetría, los neutrinos de antimateria, la partícula

de Majorana (que, como sabemos es materia y antimateria a la vez)

En cualquier caso, para provocar esos efectos gravitatorios

en nuestro Universo, tiene que ser forzosamente partículas muy pesadas

Resumen de este Big Bang alternativo:

En un Universo anterior, toda la materia, energía e información

se acumula en un agujero negro con radio NO infinitesimal (según la gravedad

cuántica de bucles)

En ese agujero negro se acumula toda la información /

complejidad del Universo anterior-à la información NO se ha perdido, NO se puede

perder, según las leyes de la Mecánica Cuántica

Punto de partida de nuestro Big Bang à

partimos de un agujero negro primordial, que está creado antes del Big Bang y

no un poco después (según afirma la teoría del doble Big Bang)

Partimos también de toda la información / complejidad del

Universo anterior, grabada en el radio finito de Schwarzschild del agujero

negro que será el padre de nuestro Big Bang

Por tanto, antes del Big Bang de nuestro Universo de materia

convencional había un Universo con las siguientes características:

-Energía máxima, en forma de energía oscura

-Información máxima---à

todos los estados cuánticos / experiencias vividas por el Universo anterior

están grabadas en el radio finito de Schwarzschild

Posibilidad: la evolución puede haber dado pasos clave

acudiendo a la información grabada en el horizonte de sucesos del Universo

oscuro / anterior

Este Universo anterior sigue existiendo

La comunicación entre este Universo oscuro y el nuestro se

lleva a cabo a través de la gravedad, aunque para ser más precisos deberíamos

decir que es a través de la antigravedad

Esa antigravedad, creada en el Universo oscuro pero

transmitida a nuestro Universo de materia ordinaria, es la que origina los

efectos de entrelazamiento cuántico que vemos

Por último, pero no menos importante, si encontráramos una

relación entre “qué es lo que llama a la energía oscura a actuar” y el espacio

-tiempo, estaríamos ante la ecuación inicial de nuestro Big Bang, de toda la

Física que conocemos

Hipótesis perfecta para explicar esta primera ecuación: la

Conjetura Maldacena, que relaciona la Relatividad General y la Mecánica

Cuántica mediante una dualidad entre un Espacio- Tiempo anti De Sitter y los

Campos Conformes

Partiendo de esta asociación, podríamos explorar dos vías de

trabajo:

-El entrelazamiento cuántico produce distorsiones del espacio

– tiempo

-Las distorsiones del espacio -tiempo producen

entrelazamiento cuántico

Posibles dinámicas causa – efecto de esta dualidad:

-Una mente cuántica y/o un Universo con un alto grado de

complejidad, capaz de originar estados de entrelazamiento, produce distorsiones

del espacio -tiempo

-Estas distorsiones del espacio – tiempo serían capaces de

producir entrelazamientos en el nuevo Big Bang de la materia ordinaria

-Esa complejidad puede venir de un Universo anterior,

colapsado en agujero negro de radio finito y, por tanto, no infinitesimal

-Esa complejidad / soluciones habrían sido grabadas en el

horizonte de sucesos de ese agujero negro

Conclusión final: la información grabada en el agujero negro

de un Universo anterior es el origen del espacio -tiempo presente en nuestro

Universo, que rige todas las interacciones existentes entre la materia

ordinaria

2.Posibles formas en que nuestro Universo (el de la

materia ordinaria) puede “pedir ayuda” al Universo del vacío cuántico

El vacío está lleno

de fluctuaciones cuánticas

Esas fluctuaciones crean una partícula y su antipartícula,

el tiempo suficiente para que se cumpla el Principio de Indeterminación de

Heisenberg

Las partículas entrelazadas emiten fotones virtuales

(electrodinámica cuántica)

Las partículas virtuales están ahí, acompañando a la

partícula real--à las partículas virtuales

aparecen y desaparecen continuamente, acompañando a la partícula entrelazada

(diagramas de Feynman)

Según la Teoría de la Supersimetría, SUSY, por cada

partícula de nuestro Universo existe otra partícula supersimétrica, mucho más

pesada que ella

Mi conclusión es que esas partículas supersimétricas del

Universo oscuro son las que provocan las grandes distorsiones del

espacio-tiempo en nuestro Universo que hacen que se produzca la acción

instantánea que existe entre partículas entrelazadas en nuestro Universo

Otra explicación alternativa a las partículas

supersimétricas sería que esta acción de distorsión del espacio-tiempo en

nuestro Universo sea causada por neutrinos de antimateria que se separaron de

del Universo de materia ordinaria en los albores del Big Bang (esa antimateria

en un Universo aparte sería la necesaria para explicar la simetría CPT)

En un momento determinado, cuando se produce la medición en

una partícula entrelazada, sus partículas virtuales hacen que entre en acción

la Métrica de Alcubierre--à sacan una enorme energía

negativa del vacío, deforman el espacio-tiempo radicalmente y le mandan

información instantánea al resto de partículas entrelazadas para que colapsen

en el estado complementario al que se midió en la partícula original

Esa información que se manda es instantánea, independiente

de la distancia a la que se encuentren las otras partículas entrelazadas--à Versión: la partícula A está instantáneamente donde la

partícula B-à ambas están en el mismo espacio y

colapsan coordinadamente

Misma explicación para los tunelajes cuánticos -à sacamos energía del vacío, vía condiciones de Métrica de

Alcubierre, para saltar la barrera de potencial

3.Explicación alternativa del experimento de la doble

rendija:

-La partícula, entrando en condiciones de la Métrica de

Alcubierre, está en ambas rendijas a la vez

-La partícula, entrando en esas condiciones, está

instantáneamente antes y después de la rejilla de la doble rendija

4.Explicación alternativa a la Fusión Nuclear

Ecuación de onda de Schroedinger, para el caso de un túnel

cuántico, tiene como solución:

http://hyperphysics.phy-astr.gsu.edu/hbasees/quantum/barr.html

El protón puede entrar dentro del núcleo por dos métodos:

-Atraviesa la barrera de la fuerza electromagnética de la

misma forma que funciona el efecto túnel

No pasa por el espacio definido por la barrera--à ahora está en el punto A (fuera de la barrera) y por estar

en condiciones de Métrica de Alcubierre, instantáneamente el protón aparece

dentro del núcleo, en el punto B

5.Explicación alternativa a la Electrodinámica

Cuántica

En la teoría aceptada, entre dos electrones se transmiten

fotones virtuales para repelerse

http://hyperphysics.phy-astr.gsu.edu/hbasees/Particles/expar.html

Mi visión

Imaginemos que los fotones virtuales están ahí (como

sabemos, el vacío no está vacío, sino que está lleno de partículas virtuales)

El electrón A está cambiando a su paso el estado cuántico de

los fotones virtuales que encuentra en su trayectoria

Los fotones virtuales hacen que aparezcan las condiciones de

la Métrica de Alcubierre -à los fotones virtuales

alterados por el paso del electrón A llegan instantáneamente a donde se encuentra

el electrón B --à los fotones virtuales NO se

mueven del alcance de los electrones y se comunican entre sí sus estados

cuánticos a través de la torsión del espacio-tiempo originada por la Métrica de

Alcubierre

Explicación más directa / revolucionaria:

Todos los electrones del Universo están entrelazados-à a veces el entrelazamiento colapsa y bajos ciertas

condiciones se mantiene. Los fotones virtuales del electrón A están ahí,

acompañando al electrón real

En un momento determinado, las partículas virtuales

involucradas hacen que entre en acción la Métrica de Alcubierre--à sacan una enorme energía negativa del vacío, deforman el

espacio-tiempo y mandan información al resto de las partículas virtuales de los

electrones que puedan estar en el recorrido del electrón A

Las partículas entrelazadas (los fotones virtuales) del

electrón B reciben la información instantáneamente y se produce la repulsión

Todos los electrones del Universo (cuyas propiedades son

idénticas) son susceptibles de poder estar en condiciones de entrelazamiento

6.Visión sobre los agujeros de gusano de

Einstein-Rosen

En la explicación original, en el centro de un agujero negro

la singularidad se puede convertir en un puente que lleva del centro del

agujero negro a otro lugar del Universo

En las matemáticas que aportó Rosen la singularidad no llega

a tamaño cero ni a densidad infinita

Kip Thorne (amigo y asesor de Carl Sagan para su película

“Contacto”) explicó las soluciones matemáticas de la ecuación de la Relatividad

General para que el agujero negro fuera transitable

https://www.konradlorenz.edu.co/blog/que-son-los-agujeros-de-gusano/

Para mantener abiertos los extremos del agujero de gusano y mantenerlo estable es necesario aportar una cantidad enorme de “energía exótica”

Mi visión

Las partículas entrelazadas están unidas por la Métrica de

Alcubierre-à por agujeros de gusano cuánticos que

están entre nosotros y que NO son los mismos que hay en las galaxias lejanas

del Universo

Los agujeros negros / de gusano responsables de la Métrica

de Alcubierre están entre nosotros y “viven” en el Universo oscuro

A escala cuántica, existe un vacío con energía negativa que

mantiene abiertos agujeros de gusano viables y estables

7.Visión sobre los infinitos mundos de Everett

https://es.wikipedia.org/wiki/Universos_paralelos

Según Wallace, esos mundos son estructuras emergentes, es decir que “no quedan directamente definidas en el lenguaje de la microfísica, pero eso no significa que sean de alguna manera independientes de la física subyacente”

Mi visión

Esos mundos / estructuras emergentes habitan / están en el

Universo oscuro

El Universo oscuro que provoca la Métrica de Alcubierre está

formado por estructuras / grandes cantidades de partículas virtuales

Estas estructuras de partículas virtuales podrían ser los

infinitos mundo / Universos de Everett--à el

fotón que va hacia la doble rendija crea, por debajo, en el vacío, un mundo de

Everett que define el resultado del experimento

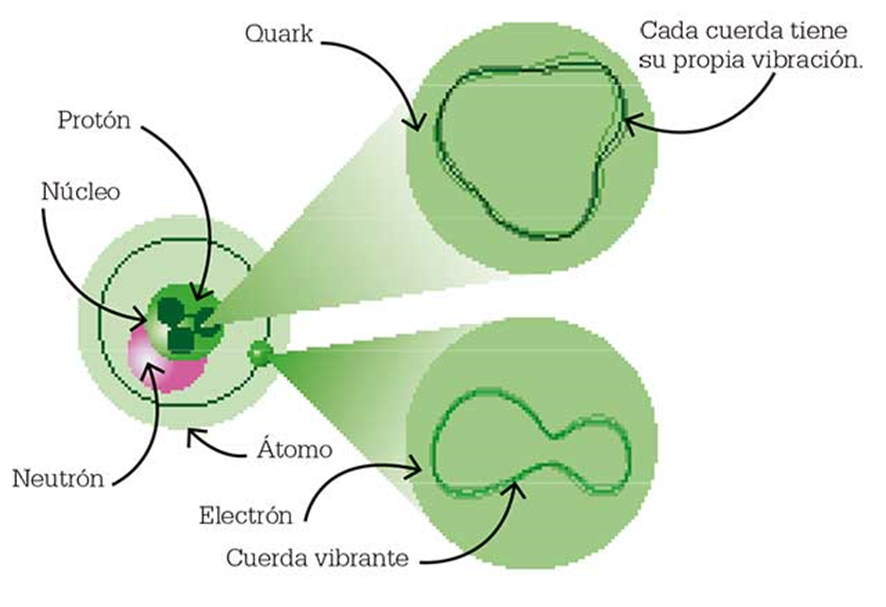

8.Implicaciones acerca de la Teoría de Cuerdas y

Supersimetría

La Supersimetría, predicción de la Teoría de Cuerdas, dice

que todas las partículas subatómicas que conocemos, como electrones, fotones y

gravitones (¿existen?) deben tener un equivalente mucho más pesado, que se

denominan “partículas S”

http://www.nocierreslosojos.com/teoria-cuerdas/

Las partículas S predichas son tan increíblemente pesadas

que, a día de hoy, los aceleradores de partículas no las detectan

Mi visión

El Universo oscuro está formado por partículas S-à crean la Métrica de Alcubierre--à

las partículas S son las responsables de la distorsión del espacio-tiempo que

da lugar a las condiciones de entrelazamiento

Las partículas, en nuestro mundo, se entrelazan

Por debajo, en el Universo oscuro las partículas S

correspondientes consiguen el entrelazamiento

Lo que postula SUSY (Supersimetría) es que a cada partícula

del Modelo Estándar le corresponde una compañera supersimétrica que tiene el

spin contrario

Es decir, por cada fermión (leptones y quarks), que tienen

spin semientero, le corresponde un bosón (que tiene spin entero) y por cada

bosón (que tienen spin entero) le corresponde u

fermión (que tiene spin semientero)

Por tanto, el número de partículas predicho por SUSY sería

el doble que en el Modelo Estándar

Como hemos dicho antes, las partículas S son increíblemente

pesadas y serían las que hay en el Universo oscuro

9.Visión sobre el Big Bang de Julian Barbour y el

entrelazamiento cuántico

Bases de la Teoría

Según Julian Barbour, la dirección del tiempo está gobernada

por la gravedad y NO por la termodinámca

https://www.abc.es/ciencia/abci-bang-pudo-fabricar-futuros-diferentes-202103070858_noticia.html

El Big Bang sería simplemente el estado con menor nivel de caos y entropía (procedería de un Rebote anterior)

A partir de ahí, se crean dos Universos, uno en el que

vivimos en el que el tiempo se mueve hacia adelante (el caos y la entropía

aumentan) y otro Universo espejo donde el tiempo se mueve hacia atrás, o sea

donde el caos disminuye, la complejidad aumenta y la entropía disminuye--à en este Universo no domina la entropía sino las fuerzas

enormes de la gravedad

Mi visión

Este segundo Universo es el Universo oscuro, que distorsiona

el espacio-tiempo, creando las condiciones de la Métrica de Alcubierre--à es el que produce los entrelazamientos y efectos túnel en

nuestro Universo

Conclusión de las partículas SUSY y del Big Bang de Barbour:

el Universo oscuro está formado por partículas S (SUSY) y camina hacia la

complejidad--à busca la complejidad, ayuda a la

complejidad cada vez que nuestro Universo “se lo pide”

Explicación más sencilla: se crean dos Big Bangs, uno para

la materia ordinaria y otro para la materia oscura

El Big Bang de la materia oscura crea un agujero negro

primordial

En el Big Bang de la materia ordinaria el tiempo va hacia

adelante ( el orden disminuye) y en el de la energía/materia oscura el tiempo

va hacia atrás (la complejidad aumenta)

10.Visión sobre el Megauniverso que respeta la

simetría CPT

Bases de la Teoría

Nuestro Universo tendría un compañero de antimateria al otro

lado del Big Bang:

https://www.epe.es/es/tendencias-21/20220907/universo-tendria-companero-antimateria-lado-75131498

Ese segundo universo sería como un mellizo del nuestro, pero

como una imagen especular: todo lo que contiene está invertido respecto al

nuestro. Incluso el tiempo, en vez de avanzar hacia el futuro, lo hace hacia el

pasado (aunque a efectos de ese universo somos nosotros los que vamos al

revés).

Si ese modelo se confirmara, significaría que el universo

que conocemos y hemos estudiado es solo una parte de una entidad mucho más

compleja, de un megauniverso complejo, formado por un lado por nuestro universo

y, por otro lado, por otro universo inverso.

Los autores de esta investigación, Latham Boyle, Kieran Finn

y Neil Turok, del Perimeter Institute for Theoretical Physics en Canadá, han

llegado a esta conclusión profundizando en las debilidades del Modelo

Cosmológico actual.

Una de estas debilidades es una pequeña contradicción no

resuelta: si nuestro Universo está en continua expansión, teóricamente estaría

violando una simetría fundamental de la naturaleza, llamada simetría CPT (por

las iniciales de Carga, Paridad y Tiempo).

Esa simetría indica que si se invierten las cargas, la

paridad y el tiempo de una interacción de partículas, esa interacción se

comportará siempre de la misma manera (será simétrica).

Los investigadores consideran que este no es el caso del

Universo que vemos a nuestro alrededor, en el que el tiempo avanza a medida que

el espacio se expande, y en el que hay más materia que antimateria. Sin

embargo, esa simetría sí se cumple en el caso de que también exista ese

Antiuniverso.

En el megauniverso complejo se cumpliría la simetría CPT

porque en una de sus manifestaciones (el Antiuniverso) no solo el tiempo

transcurre en una dirección opuesta a la del nuestro, sino que también está

dominado por la antimateria. La imagen especular de ambos universos mellizos

compensa los posibles desajustes.

Estos autores consideran que ese modelo simétrico de

megauniverso complejo, integrado por dos universos especulares, no solo es

consistente con la historia de expansión cósmica conocida, sino que también

proporciona una explicación directa para la materia oscura.

Por un lado, ese megauniverso complejo, integrado por dos

universos opuestos, puede expandirse y llenarse de partículas sin necesidad de

un largo período de rápida expansión conocido como inflación (que tal vez

erróneamente hemos atribuido a nuestro universo), por lo que no violaría la

simetría básica de la naturaleza (CPT).

Por otro lado, ese universo complejo resuelve también el

misterio de la materia oscura: no sería más que un nuevo tipo de neutrino,

todavía no observado, que solo puede existir en el “otro” universo.

Mi visión

Ese Antiuniverso, compuesto de partículas muy pesadas,

neutrinos y/o partículas S, es el que distorsiona nuestro espacio-tiempo

mediante la Métrica de Alcubierre

Este Antiuniverso espejo interactúa con nuestro Universo a

través de la gravedad y explicaría la paradoja de la constante de Hubble, que

indica que el Universo se está expandiendo más deprisa que lo calculado en el

Modelo Cosmológico actual

11.Big Bang a partir de un agujero negro creado en un

Universo anterior, agujero negro que respeta la llamada “Paradoja de la

Información”, mediante el “Principio Holográfico”

Bases de la Teoría

El principio holográfico: el más bello avance hacia la

gravedad cuántica:

La termodinámica de los agujeros negros surgió porque era

necesario asignarles entropía dentro de un marco teórico adecuado: si no la

poseían, era posible cargarse la entropía entera del Universo arrojando cosas a

un agujero negro

Surge combinando agujeros negros, determinismo y gravedad

cuántica

Hawking decía que lo que radiaban los agujeros negros era

completamente aleatorio

Esta interpretación de Hawking NO era respetuosa con el

determinismo de la función de onda de la Mecánica Cuántica

La función de onda es determinista---à

si conoces la función de onda de un sistema puedes calcular de forma

determinista su evolución siguiendo la ecuación de Schroedinger, para estimar

cómo será dicha función un tiempo después

Más aún, la función de onda propaga toda la información del

sistema cuántico, por lo que NO es concebible que sea destructible

En Mecánica Estadística, cuando hablamos de la entropía de

un sistema estamos contando la cantidad de información de la que disponemos

sobre dicho objeto / sistema

Bekenstein --à la entropía de los agujeros negros es una entropía

debida al entrelazamiento cuántico

Las partículas de fuera del agujero negro y las de dentro

quedan entrelazadas cuando se formaba el agujero negro

Fórmula de Bekenstein

S: entropía del agujero negro

A: área del agujero negro

Propuesta del Principio Holográfico: lo que vemos que sucede en el horizonte de un agujero negro es una representación perfecta de lo que sucede en el interior--à estaríamos viendo el interior del agujero sin necesidad de entrar en él

Restricción: un cierto volumen físico de nuestro Universo NO

puede contener más información que la que se puede codificar en su frontera

¿Cuál sería la unidad mínima de información?, ¿el bit

cósmico?

A es el área de Planck

Con este razonamiento, la propuesta fue que el horizonte del

agujero negro contenía un bit de información por cada pequeño recinto de tamaño

igual al área de Planck sobre su superficie. Un agujero negro que almacenase

tres millones de bits de información cuántica tendría que tener un área de tres

millones de áreas de Planck, que son diminutas.

Si nos vamos a un caso bien sencillo, como podría ser un

agujero negro de un centímetro de radio (que es lo que mediría el de la Tierra

si esta se comprimiese), la información que podría almacenar sería de:

Para calcular el área del agujero hemos usado la fórmula del área de una esfera.

Esto es una barbaridad. Un ordenador normal almacena no más

de 10 elevado a 13 bits, una cantidad prácticamente nula en comparación con la

que nos ha salido. La propia Tierra, en principio, requiere menos bits de

información para ser descrita que esa cantidad.

Pongamos otro ejemplo planteado por el propio Susskind,

rellenando todo el universo observable de libros. Si cada carácter en un libro

lo consideramos con un bit, un libro posee aproximadamente 6000 bits por

centímetro cúbico. El tamaño del universo observable, por otra parte, son 4 por

10 elevado a 80 metros cúbicos. Toda esa barbaridad de libros podrían ser

acogidos como bits en la frontera de un agujero negro de apenas 7 kilómetros:

Consecuentemente, la información en el universo está muy poco concentrada en comparación con lo que podría estarlo.

La propuesta de ‘t Hooft y Susskind se conoce como principio

holográfico porque trata el interior del agujero negro como si fuese un

holograma codificado en su superficie, del mismo modo que en películas de

ciencia ficción como Star Wars las imágenes tridimensionales que usan para

comunicarse están codificadas en el plano que las genera.

Dentro de la propuesta, se incluye el axioma de que en el

universo en un volumen delimitado por cierta área no puede haber mayor cantidad

de información que la que tendría un agujero negro con dicha área y que,

análogamente, dada una cierta cantidad de información no se puede comprimir más

que lo que la comprimiría un agujero negro. De haber en el cosmos algo con

mayor densidad de información que un agujero negro la propuesta tendría que ser

revisada, como poco reduciendo el tamaño de los bits para que entren más en

menos sitio.

Finalmente, gracias al principio holográfico, en el agujero

negro en principio dejaron de haber paradojas. La información no se pierde

porque queda registrada constantemente en la frontera del agujero negro y los

dos observadores llegan a las mismas conclusiones.

Leonard Susskind se lanzó a la aventura explicando esta

propuesta en su artículo “El universo como un holograma”

Determinismo holográfico:

A partir de lo expuesto resulta obvio que la paradoja de la

información desaparece. Las funciones de onda se propagan y evolucionan deterministamente

codificadas en el horizonte del agujero negro para el observador externo,

mientras que el observador interno verá que las cosas entran y más adelante

salen despedidas en algún momento como radiación térmica, pero sin haber

perdido su identidad.

Mi visión

En un Universo anterior, toda la materia, energía e

información se acumula en un agujero negro con radio NO infinitesimal

(según la gravedad cuántica de bucles)

En ese agujero negro se acumula toda la información /

complejidad del Universo anteriorà la información NO se ha

perdido, NO se puede perder, según las leyes de la Mecánica Cuántica

Punto de partida de nuestro Big Bang--à partimos de un agujero negro primordial, que está creado

antes del Big Bang y no un poco después (según afirma la teoría del doble Big

Bang)

Partimos también de toda la información / complejidad del

Universo anterior, grabada en el radio finito de Schwarzschild del agujero

negro que será el padre de nuestro Big Bang

Como resumen, antes del Big Bang de nuestro Universo había:

-Energía máxima, en forma de energía oscura

-Información máxima--à

todos los estados cuánticos / experiencias vividas por el Universo anterior

están grabadas en el radio finito de Schwarzschild

¿Qué ocurre cuando comienza nuestro Big Bang?:

-Se crean todas las partículas elementales

-Se produce la nucleosíntesis / fusiones nucleares sin

necesidad de llegar a millones de grados --à

pasamos protones de fuera del núcleo de hidrógeno al interior, por efecto túnel

cuántico

¿Cómo se produce este fenómeno de creación en nuestro Big

Bang?: la información del agujero negro sabe cómo crear un nuevo Universo y la

energía lo lleva a cabo con la poderosa herramienta de la enorme distorsión del

espacio-tiempo que se lleva a cabo si entramos en condiciones de la Métrica de

Alcubierre

¿Quién es el verdadero actor de cómo será la evolución del

Big Bang que se acaba de crear?: la información / experiencia acumulada en el

agujero negro / fin de los tiempos del Universo anterior

En el Universo anterior, la flecha del tiempo termodinámico

iba hacia atrás (Universo paralelo de Barbour)--à ese

Universo caminaba hacia la mínima entropía, la máxima complejidad

Por último, pero no menos importante: estas distorsiones del

espacio-tiempo deben haber provocado ondas gravitacionales que deberían ser

observables

12.Visión sobre Superconductividad y Pares de Cooper

Bases de la teoría

En vez de la explicación clásica de cambios en la red de

iones-à esos electrones del par cogen energía

del vacío, entran en fase de entrelazamiento, los dos electrones responden a la

misma ecuación de onda--à cada uno de ellos sabe en

cada momento lo que hace el otro y su tránsito a través de la red de iones

positivos es mucho más fácil que el que habrían encontrado por separado

Mi visión

“Los electrones que forman los pares de Cooper buscan ayuda

en el Universo oscuro”--à entran en condiciones de la

Métrica de Alcubierre

Además, el Universo oscuro le da las claves para transitar

más fácil por la red de iones positivos

Y ello es así porque el Universo oscuro está hecho para

permitir tránsitos hacia la complejidad (Big Bang de Barbour), para buscar

soluciones más complejas

Por último, esta petición de ayuda, este entrelazamiento

hace que todos los pares de Cooper del superconductor estén entrelazados--à la formación de pares de Cooper tiene lugar simultáneamente

en todo el conductor, por lo que la conducción eléctrica se convierte en la

“marcha de un pequeño ejército de Pares de Cooper que no hay nadie que lo

detenga”

13.Reversión del estado de un fotón (experimento hecho

en la Universidad de Austria)

Bases de la Teoría

Si corremos el tiempo hacia atrás, podríamos saber todos los

estados que ha tenido ese fotón a lo largo de su historia---à `podríamos llegar hasta el momento en que se creó, cerca

del Big Bang

Para hacer que el fotón vaya hacia atrás, lo hacemos con

protocolos de “rebobinado universal”

Mi visión

Nos ayudamos del Universo oscuro, donde el tiempo va hacia

atrás, el orden aumenta y la entropía disminuye

El estado del electrón irá hacia atrás si conseguimos entrar

en distorsiones del espacio-tiempo producidas por la Métrica de Alcubierre

Si logramos revertir el tiempo, o sea los estados de un

fotón, ¿podríamos conseguir lo mismo con una célula?--à

revertiríamos su estado de célula adulta al de célula pluripotencial

¿Misma dinámica para los saltos evolutivos? --à en vez de lucha / competición en los procesos evolutivos--à cooperación, que se consigue “pidiendo ayuda” al Universo

oscuro, al agujero primordial, al vacío cuántico, que está regido por un tempo

que va hacia atrás, por la transición hacia una mayor complejidad, por la

creación de estructuras más complejas

14.Acción conjunta energía oscura – materia oscura del

Antiuniverso para provocar distorsiones del espacio – tiempo en nuestro

Universo. Aplicación de la Conjetura Maldacena

No olvidemos que la masa no es nada más que energía

condensada

La energía oscura, cuando quiere crear una fuente constante

de repulsión antigravitatoria, crea un agujero negro primordial de materia

negativa, pero cuando ese Universo oscuro es requerido de manera puntual para

que su energía, por ejemplo, ayude a la materia ordinaria a entrar en

condiciones de entrelazamiento o a traspasar un túnel cuántico---à acude directamente a la energía oscura y NO se vale del

agujero negro primordial

Así la acción requerida sería más flexible y puntual: acudo

allí donde haya entrelazamiento o túneles cuánticos o doble rendija, hago la

ayuda puntual / la acción puntual y cuando acaba mi misión (cuando se deshace

el entrelazamiento) yo, energía oscura, desaparezco y me voy a otro sitio donde

requieran mis servicios

Así, habría chorros puntuales de energía oscura, que

producirían, por ejemplo, esos tunelajes

El mundo sería así más simple--à

la energía oscura, directamente, es la que produce las distorsiones del espacio

– tiempo

La ecuación de la

Relatividad General relaciona materia y espacio-tiempo

Habría que

encontrar una ecuación para relacionar energía oscura y espacio-tiempo

Hipótesis perfecta

para explicar esta primera ecuación que originaría toda la Física que conocemos:

la Conjetura Maldacena, que relaciona la Relatividad General y la Mecánica

Cuántica mediante una dualidad entre un Espacio- Tiempo anti De Sitter y los Campos

Conformes

Partiendo de esta

asociación, podríamos explorar dos vías de trabajo:

-El entrelazamiento

cuántico produce distorsiones del espacio – tiempo

-Las distorsiones

del espacio -tiempo producen entrelazamiento cuántico

Posibles dinámicas causa

– efecto de esta dualidad:

-Una mente cuántica

y/o un Universo con un alto grado de complejidad, capaz de originar estados de

entrelazamiento, produce distorsiones del espacio -tiempo

-Estas distorsiones

del espacio – tiempo serían capaces de producir entrelazamientos en el nuevo

Big Bang de la materia ordinaria

-Esa complejidad

puede venir de un Universo anterior, colapsado en agujero negro de radio finito

y, por tanto, no infinitesimal

-Esa complejidad /

soluciones habrían sido grabadas en el horizonte de sucesos de ese agujero

negro

Conclusión final: la

información grabada en el agujero negro de un Universo anterior es el origen

del espacio -tiempo presente en nuestro Universo, que rige todas las

interacciones existentes entre la materia ordinaria

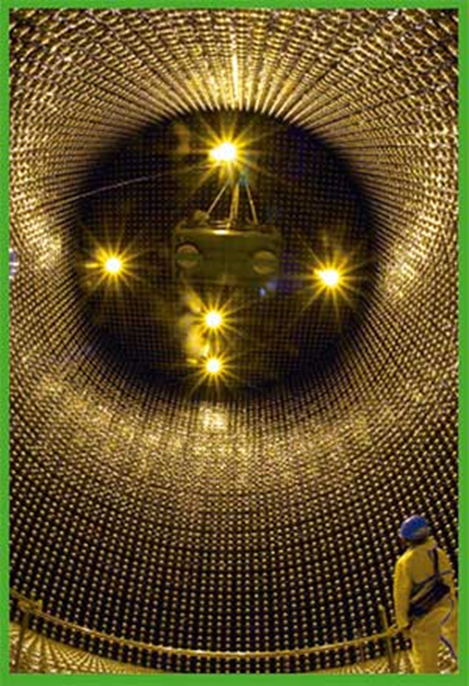

15.Fusión nuclear artificial vs fusión solar y

tunelaje cuántico

Teoría actual

La fusión nuclear en el Sol se lleva a cabo solamente

venciendo la repulsión electromagnética con millones de grados de temperatura y

una inmensa presión

Los astrofísicos saben que eso no basta y que en las fases

finales solo consiguen entrar los protones al núcleo de los átomos de Hidrógeno

vía tunelaje

Actualmente, los experimentos de fusión nuclear que se

llevan a cabo en todo el mundo se basan en el primer concepto citado

Mi visión

Deberíamos tratar de provocar el tunelaje para no tener que

llegar a esas temperaturas tan extremas

¿Cómo provocar ese tunelaje cuántico?: vía torsión del

espacio - tiempo / Métrica de Alcubierre

Para que haya torsión del espacio 7 tiempo deberíamos poner

en el plasma las condiciones de entrelazamiento----> debemos “llamar a la

energía oscura”

La energía oscura ayuda al protón que está fuera del núcleo,

vía condiciones de Métrica de Alcubierre, a pasar la barrera de potencial y

entrar en el núcleo de Hidrógeno

Resumen: la fusión nuclear que se produce en el Sol y resto

de estrellas se produce porque los protones que quieren entrar en el núcleo

“piden ayuda” a un agujero negro primordial que se formó mucho antes que el Sol

16.Alternativa a la nucleogénesis aceptada del Big

Bang

Los seres humanos, la ciencia, podrían crear Big Bangs

tranquilos acudiendo, para las diferentes etapas de nucleógenesis de los

elementos, a “ayudas” de la energía oscura / agujeros negros primordiales /

distorsiones del espacio-tiempo

17.Explicación de la levitación

Primera explicación: si estamos en condiciones de

superconductividad, aparecerá la levitación:

Efecto Meissner

El efecto Meissner, también denominado efecto

Meissner-Ochsenfeld, consiste en la desaparición total del flujo del campo magnético en el interior de un

material superconductor por debajo de su temperatura crítica. Fue descubierto por Walter

Meissner y Robert Ochsenfeld en 1933 midiendo la

distribución de flujo en el exterior de muestras de plomo y estaño enfriados

por debajo de su temperatura crítica en presencia de un campo magnético.

Meissner y Ochsenfeld encontraron que el campo magnético se

anula completamente en el interior del material superconductor y que las líneas

de campo magnético son expulsadas del interior del material, por lo que este se

comporta como un material diamagnético perfecto.

El efecto Meissner es una de las propiedades que definen la superconductividad

y su descubrimiento sirvió para deducir que la aparición de la

superconductividad es una transición de fase a un estado diferente.

La expulsión del campo magnético del material superconductor

posibilita la formación de efectos curiosos, como la levitación de un imán

sobre un material superconductor a baja temperatura que se muestra en la figura.

https://es.wikipedia.org/wiki/Efecto_Meissner

Mi visión

Vencemos la fuerza de la gravedad acudiendo a la energía

oscura, que es antigravedad

Esa antigravedad es originada por distorsiones del

espacio-tiempo originadas en el Universo oscuro

El Universo oscuro se comunica con el nuestro haciendo

entrelazamientos entre partículas y proporcionando energía antigravitatoria

para levantar cosas, como partículas de polvo en la habitación de

“Interstellar”

18.Explicación alternativa a cómo sacar energía del

vacío

La opción sería ir directamente al vacío buscando, por

método parecido al efecto Casemir, pero aprovechándonos del efecto

antigravitatorio generado por la Métrica de Alcubierre para sacar del vacío la

partícula de cada par generado en esas fluctuaciones y traerla al

espacio-tiempo de nuestro Universo

Opción más poderosa: aprovechar la energía oscura / la

distorsión del espacio – tiempo para hacer pasar los electrones de cualquier

elemento químico desde una órbita estable a las órbitas más exteriores--à el electrón pasaría

de la órbita 1 (espacio A) a la órbita 3 (espacio B) por distorsión del

espacio-tiempo producido por nuestra “llamada” a la energía oscura

Después, como siempre, ese electrón, al estar inestable en

una órbita excitada, volvería a la órbita original emitiendo energía

electromagnética (fotones) …..que habría salido del vacío

Nota final. Si esto lo hacemos para muchos electrones, de

diferentes átomos de un mismo elemento, podemos conseguir que todos los

electrones estén sincronizados, y bajen todos a la vez a sus órbitas estables

adicionales---à conseguiríamos reproducir el

efecto-láser (muchísima más energía, generada por ondas electromagnéticas

sincronizadas)….y todo habría salido del vacío

19.Resonancia Magnética, entrelazamiento y estado de

consciencia en nuestro cerebro

Según un reportaje de la BBC, David López, Doctor en

Neurociencias y su equipo, cuando un paciente al que se le está haciendo una

Resonancia está despierto, las señales devueltas por el cuerpo humano son más

fuertes cuando el paciente se queda dormido

El "cerebro cuántico", la audaz teoría que puede

ayudar a resolver el misterio de cómo surge la conciencia humana:

https://www.bbc.com/mundo/noticias-64065872

David afirma que durante la Resonancia los protones están

entrelazados “porque hay una función que etá mediando ese entrelazado y que esa

función que hace de mediadora es la consciencia”

Y continúa: "No

podemos medirla directamente, pero medimos los protones".

El científico explicó a BBC Mundo que "la gravedad

cuántica es un mundo puramente teórico que todavía no se ha explicado

experimentalmente, que quiere unir dos teorías que a priori no son compatibles

(la mecánica cuántica y la teoría de la relatividad). Para ello han creado la

figura del gravitón, que es algo que no se sabe cómo es pero que sería el

puente entre las dos teorías"

Mi visión

Este experimento indica un hecho clave: la consciencia

influye sobre el estado de spin de los protones de los núcleos de las moléculas

de agua de nuestro cuerpo, lo cual quiere decir que hay una conexión

mente-cuerpo directa y demostrable, a través del resultado de la Resonancia

No hace falta acudir

a la existencia del gravitón para explicar esta relación entre consciencia y

entrelazamiento

De existir esta relación, y siguiendo el argumento base de

este documento, esto querría decir que la consciencia es la que “llama” al

Universo oscuro, que crea la distorsión del espacio-tiempo que provoca el

entrelazamiento de los protones de las moléculas de agua del cuerpo, cuyo

decaimiento origina la señales detectadas en las Resonancias

Conclusión más enigmática: ¿es la consciencia la que

controla la energía oscura del Universo del vacío cuántico?

De acuerdo con este planteamiento, habría que pensar en una

ecuación del Big Bang de nuestro Universo en los siguientes términos:

Lado izquierdo de la ecuación: consciencia = lado derecho:

fuertes distorsiones del espacio-tiempo

Siguiente ecuación: la Teoría General de la Relatividad-à el espacio-tiempo le dice a la materia cómo moverse

(parafraseando a John Wheeler)

Ambos Universos estarán comunicados a través de ondas gravitacionales

(tal como propone el físico Kip Thorne en Interstellar)

Los efectos en nuestro Universo serían fuerzas

antigravitatorias creadas por el Universo oscuro

¿Cómo se realizaría esta conexión mente-células de nuestro

cuerpo?

Mi visión

La consciencia, en determinadas condiciones, crea un estado

de entrelazamiento de todos los neuropéptidos de nuestro cuerpo

Para ello, se ha conseguido activar el Universo oscuro, que

por medio de la distorsión del espacio-tiempo, es el último responsable de ese

entrelazamiento

La consciencia llega a estado de entrelazamiento solo con

determinados pensamientos, por ejemplo, cuando estamos en estado de

inspiración, meditación intensa, de urgencia máxima, etc.

20.Viajes al pasado

Mi versión

Los estados cuánticos, según la Mecánica Cuántica, no se

pierden

Cada estado cuántico es un mundo que ha existido

Los mundos originados por cada uno de esos pensamientos

clave siguen ahí, en el cerebro, en la memoria

Bajo este prisma, un mundo “efecto” (un pensamiento concreto)

puede existir perfectamente antes que un mundo causa

Esto significaría se puede viajar a través del tiempo: a

través de un pensamiento “efecto” puedo investigar las causas que lo hicieron

posible--àveo el efecto e investigo las posibles

cauasas-à pienso--à

efecto Alcubierre--à viajes instantáneos entre

diferentes estados cuánticos que han ocurrido--à

viajes atrás en el tiempo

No viajamos al pasado como personas sino como estados

cuánticos que han ocurrido (y que por tanto han quedado grabadas en nuestro cerebro)

en nuestro pasado

21.Los agujeros negros crecen no solamente por la

materia que absorben, sino sobre todo por la energía oscura del vacío

Loa agujeros negros crecen por la energía oscura que

sacan del vacío

Descubren la fuente máxima de energía oscura, los agujeros

negros:

https://ecoosfera.com/sci-innovacion/energia-oscura-fuente-agujeros-negros/?utm_content=cmp-true

Hasta ahora se creía que los agujeros negros estaban en

constante crecimiento gracias a las cantidades inmensas de materia que devoran

debido a sus campos gravitacionales, pero las observaciones de Farrah y Croker,

sugieren que es en realidad la energía oscura la que genera este

crecimiento. Según sus conclusiones, los agujeros negros

contienen energía de vacío y están acoplados a la expansión del Universo,

aumentando en masa a medida que el cosmos se expande. Acorde con esta nueva

investigación, la cantidad medida de energía oscura en el cosmos, puede

explicarse gracias a la energía de vacío acumulada en los agujeros negros.

“Esta medición que explica por qué el Universo se acelera

ahora, ofrece una hermosa visión de la fuerza real de la gravedad de Einstein”.

Mi visión

Impresionante descubrimiento, hecho a partir de

observaciones de agujeros negros supermasivos que viven dentro de un grupo de

galaxias elípticas del Universo primitivo

Solo me queda por añadir: ahí está la energía oscura en todo

su esplendor, en esos agujeros negros primordiales

ANEXOS

Anexo 1. Ecuación de onda de Schroedinger, aplicada al

caso de un túnel cuántico

Blog: “El efecto túnel a detalle”

https://tunelcuantico.home.blog/2019/02/16/el-efecto-tunel-a-detalle/

Ecuación de onda de Schroedinger:

Ecuación de onda de Schroedinger para cada una de las tres

regiones:

Soluciones de las funciones de onda en las regiones i y III:

Es una expresión oscilatoria: son ondas

Solución en la región II:

No es una expresión oscilatoria

Anexo 2. Dualidad onda-partícula, Postulado de Louis de Broglie y longitudes de onda de un electrón y de una pelota de beisbol

Ver post “Dualidad onda-corpúsculo”

https://es.wikipedia.org/wiki/Dualidad_onda_corp%C3%BAsculo

La dualidad onda-corpúsculo, también

llamada dualidad onda-partícula es un fenómeno

cuántico, bien comprobado empíricamente, por el cual muchas partículas pueden exhibir comportamientos

típicos de ondas en unos experimentos mientras aparecen como partículas

compactas y localizadas en otros experimentos. Dado ese comportamiento dual, es

típico de los objetos mecanocúanticos,

donde algunas partículas pueden presentar interacciones muy localizadas y como

ondas exhiben el fenómeno de la interferencia.

De acuerdo con la física

clásica existen diferencias claras entre onda y partícula. Una partícula tiene una posición

definida en el espacio y tiene masa mientras que una onda se extiende en el

espacio caracterizándose por tener una velocidad definida y masa nula.

Actualmente se considera que la dualidad onda-partícula es

un “concepto de la mecánica cuántica según el cual no hay diferencias

fundamentales entre partículas y ondas: las partículas pueden comportarse como

ondas y viceversa”. (Stephen

Hawking, 2001)

Este es un hecho comprobado experimentalmente en múltiples

ocasiones. Fue introducido por Louis-Victor de Broglie, físico francés de

principios del siglo xx. En 1924 en su tesis

doctoral, inspirada en experimentos sobre la difracción de electrones, propuso

la existencia de ondas de materia, es decir que toda materia tenía una onda

asociada a ella. Esta idea revolucionaria, fundada en la analogía con que

la radiación tenía

una partícula asociada, propiedad ya demostrada entonces, no despertó gran

interés, pese a lo acertado de sus planteamientos, ya que no tenía evidencias

de producirse. Sin embargo, Einstein reconoció

su importancia y cinco años después, en 1929, De Broglie

recibió el Nobel en Física por su trabajo.

Su trabajo decía que la longitud

de onda de la onda asociada a la materia era:

Longitudes de onda del electrón y de una pelota de beisbol:

http://hyperphysics.phy-astr.gsu.edu/hbasees/debrog.html

Si se explora los valores de la longitud de onda de los objetos macroscópicos ordinarios como pelotas de béisbol, se encontrará que sus longitudes de onda de DeBroglie son ridículamente pequeñas. La comparación de la potencia de diez para la longitud de onda, mostrará que las longitudes de onda de los objetos ordinarios son mucho más pequeñas que un núcleo. La implicación es que para los objetos ordinarios, nunca se verá ninguna evidencia de su naturaleza ondulatoria, y para todos los fines prácticos pueden considerarse como partículas.

Anexo 3. Principio de incertidumbre de Heisenberg para

la energía-tiempo

Ver post: “Relación de indeterminación de Heisenberg”:

https://es.wikipedia.org/wiki/Relaci%C3%B3n_de_indeterminaci%C3%B3n_de_Heisenberg

Esta forma es la que se utiliza en mecánica cuántica para explorar las consecuencias de la formación de partículas virtuales, utilizadas para estudiar los estados intermedios de una interacción. Esta forma del principio de indeterminación es también la utilizada para estudiar el concepto de energía del vacío.

Anexo 4. Experimento de la doble rendija

Ver PDF:

Sanchez-Jesus Double slit experiment interpretation:

Interpretación del experimento de la doble rendija

Para esta interpretación, consideraremos las partículas como

los vehículos (los transmisores) de la energía pero siendo estas partículas

indetectables de por sí (no pueden interactuar directamente con nada). Las

interacciones no son provocadas por la partícula en sí sino por los portadores

de fuerza que emite (generalmente los fotones virtuales). Cuando un detector

detecta un electrón, realmente no lo “toca”, ni siquiera lo “ve”, sino que

interactúa con su campo electromagnético (con sus fotones virtuales). El

electrón está emitiendo continuamente una nube de fotones virtuales que le

rodea. La distribución de estos fotones está definida por una función de onda.

El detector no interactúa con el electrón mismo, sino con su nube de fotones

virtuales. Cuando el electrón pasa por una rendija, toda su nube de fotones

pasa por las dos rendijas así que interfiere consigo misma y se distribuye

según el patrón de interferencia. Para que uno de estos fotones interactúe con

la pantalla, la energía del electrón debe ser usada en ese punto –si no se usa

esa energía sencillamente no habría interacción-. Si una vez hecha una

interacción por un fotón con la pantalla, otro fotón intentara interactuar con

la pantalla otra vez, no habría interacción ya que no habría más energía que

permitiera que esa interacción ocurriera. Así que, cada vez que enviamos un

electrón, la pantalla mostrará sólo un punto, pero el patrón total se definirá

por la posibilidad de interacción (esto es, por la distribución de la nube de

fotones, una vez ha pasado por las dos rendijas, es decir, por el patrón de

interferencia). Esto significa que el electrón, la partícula indetectable (pero

transmisor de la energía), podría pasar sólo por una rendija –o quizás no,

realmente no nos importa- pero sus posibilidades de ser detectado pasan

realmente por ambas rendijas (en forma de una nube de fotones que interfiere

consigo misma).

Anexo 5. Integral de caminos de Feynman

Cómo nuestra realidad puede ser la suma de todas las

realidades posibles:

https://culturacientifica.com/2023/04/04/integral-de-caminos/

La ecuación, aunque adorna las páginas de miles de

publicaciones de física, es más una filosofía que una receta rigurosa. Sugiere

que nuestra realidad es una especie de mezcla, una suma, de todas las

posibilidades imaginables. Pero no les dice a los investigadores exactamente

cómo llevar a cabo la suma. Así que la comunidad científica ha pasado décadas

desarrollando un arsenal de estrategias de aproximación para construir y

calcular la integral para diferentes sistemas cuánticos.

Las aproximaciones funcionan lo suficientemente bien como

para que físicas intrépidas como Loll busquen ahora la integral de caminos

definitiva: una que combina todas las formas concebibles de espacio y tiempo y

produce un universo con la forma del nuestro como resultado neto. Pero en esta

búsqueda por demostrar que la realidad es de hecho la suma de todas las

realidades posibles, se enfrentan a una profunda confusión sobre qué

posibilidades deberían entrar en la suma.

Anexo 6. Tipos de partículas virtuales

Ver entrada: “Partícula virtual”

https://es.wikipedia.org/wiki/Part%C3%ADcula_virtual

Bosones virtuales

En el modelo estándar, las

fuerzas fundamentales están transmitidas por los bosones

de gauge. Cuando estos bosones transmiten las fuerzas son partículas virtuales,

y son creados en el vacío. Incluso en el vacío más perfecto, ya sea el que se cree

en un laboratorio, el espacio intergaláctico, o el vacío

interatómico, son creados continuamente bosones de gauge con una existencia

extremadamente breve. La mecánica

cuántica predice que la energía del vacío nunca puede llegar a ser

cero. La energía menor posible del vacío se llama energía

del punto cero, y es precisamente esta poca (aunque no nula) energía la de

las partículas virtuales. Este modelo del vacío se llama vacío

cuántico.

La transmisión de las fuerzas entre las distintas cargas de

cada interacción está descrita por la teoría cuántica de campos, que describe

cómo los bosones de gauge virtuales se transmiten a través del vacío polarizado

entre las cargas reales.3

Algunos de estos bosones también se presentan como partículas reales en

distintos fenómenos:

- Los fotones son

partículas reales cuando los observamos en cualquier tipo de radiación electromagnética, como

la luz o

los rayos

X. En cambio, cuando transmiten la interacción electromagnética entre

partículas con carga eléctrica los fotones son

virtuales.

- Los gluones reales

forman los llamados mesones y bariones híbridos, así como las glubolas o bolas gluónicas (la

existencia de ambos aún no está comprobada). Los gluones que transmiten

la interacción fuerte entre

partículas con carga de color son virtuales.

Pero una cuestión aún a resolver es saber si todos los bosones

de gauge sin masa que existen, incluidos los que arriba se exponen como reales,

son al fin y al cabo virtuales. Estas partículas se mueven a la velocidad de la luz, y por tanto, atendiendo a

la teoría de la relatividad de Albert

Einstein, el tiempo que tardan en propagarse entre dos puntos cualesquiera

del universo es instantáneo desde el punto de vista de las partículas.

Entonces, al ser el tiempo de emisión y absorción instantáneo, ¿serían

virtuales?

Pares virtuales de partícula-antipartícula

No solo surgen bosones de gauge en el vacío

cuántico, sino también pares partícula-antipartícula;

como por ejemplo pares electrón-positrón, o pares quark

arriba-antiquark

arriba, etc.

Siempre debe crearse una partícula con su antipartícula,

conservándose así el número

leptónico o bariónico (dos números

cuánticos) del universo. Las partículas que surgen de este modo son virtuales

porque en cuanto aparecen, tienen tan poca energía que al instante se aniquilan entre sí.

Estos pares virtuales se usan como un esquema explicativo

para justificar que la energía del punto cero del vacío no es

estrictamente nula. Además la radiación de Hawking puede recibir una

explicación intuitiva en términos de la creación de estos pares virtuales de

partícula-antipartícula.

Anexo 7. Gravedad cuántica de bucles

¿Qué es la Gravedad Cuántica de Bucles?:

https://www.curiosamente.com/videos/que-es-la-gravedad-cuantica-de-bucles

Para la Teoría Cuántica de bucles, formulada por científicos

como John Baez, Carlo Rovelli y Lee Smolin, el espacio no es continuo, es

decir, no se puede dividir infinitamente: hay una unidad mínima de distancia.

El espacio-tiempo está “granulado”. Piensa en la pantalla de tu televisión o tu

teléfono móvil. Puedes ver cómo un punto de luz se mueve de un lado a otro de

manera aparentemente continua. Si te acercas lo suficiente puedes notar que la

pantalla está dividida en decenas de miles de cuadritos que forman la imagen.

Estos cuadritos se llaman “pixeles”: son la unidad mínima de la imagen: no se

pueden subdividir más. Y un punto de luz que se mueve puede estar en este

pixel, o en el pixel contiguo, pero no se puede mover “medio pixel”.

La propuesta de la Gravedad Cuántica de bucles es que el

espacio también está así: pixelizado. O más propiamente “cuantizado”, de la

misma manera que la energía sólo se puede transferir en paquetes llamados

“cuantos”. No sólo la materia y la energía, sino el espacio mismo tiene una

estructura atómica. La distancia mínima se llama “distancia de plank”, es

millones de veces más pequeña que un electrón, y nada se puede

mover en distancias menores.

¿Cómo se estructura?

La idea es que el espacio-tiempo está estructurado en redes

de pequeñísimos rizos o bucles conectados entre sí. Estas redes se llaman

“redes de spin”, y son estudiadas mediante una rama de las matemáticas llamada

“teoría de grafos”, que se ocupa de calcular los modos posibles en los que se

relacionan los vértices y las aristas de la red. Una red de spin representa el

estado cuántico de un campo gravitacional. Y no es fijo: está en constante

flujo.

Una hipótesis meramente especulativa dice que las partículas

subatómicas podrían ser “nudos” o “trenzas” dentro de la red de spin. Esta por

ejemplo podría ser un electrón, mientras que ésta podría ser un positrón. Acá

tenemos un electrón neutrino y éste, un anti-neutrino. Y la deformación del

espacio-tiempo que se manifiesta como gravedad a escalas planetarias o

galácticas, empieza aquí, en la escala más pequeña posible. El universo sería

una impresionantemente complicada red de spin.

La antigua idea del espacio y el tiempo como un escenario

donde ocurren las cosas ya no aplica. Una red de spin no está en el tiempo y el

espacio: sino que es el espacio-tiempo mismo.

Anexo 8. Energía del vacío. La mayor discordancia de

la historia de la ciencia

¿Crear el vacío?:

http://www.javierdelucas.es/vaciomedir.htm

Las medidas astronómicas basadas en el movimiento del

sistema solar y sobre todo de galaxias lejanas se han traducido en un valor

máximo para la constante cosmológica:

|V|<10-56 cm-2

Este valor máximo implica que la densidad de energía

del vacío tiene que ser menor que 10-9 erg/cm3. A

continuación veamos qué nos dicen las estimaciones teóricas. Si intentamos

expresar la energía del vacío en unidades de Planck que constituyen el sistema

de unidades fundamental en mecánica cuántica obtenemos:

Eplanck=(hc5/G)1/2=1019 GeV

Entonces tenemos que la densidad de energía del vacío

sería:

Pvac=(1019GeV)4=1076 GeV=10114 erg/cm3

¡Esto es una cantidad inmensa de energía! La

discrepancia es por tanto de 123 órdenes de magnitud. Este

valor es de una magnitud inconcebible para el cerebro humano. Por eso se dice

que esta estimación teórica constituye la discordancia entre teoría y

experimento más grande de la historia de la ciencia.

El cálculo de la energía del vacío de la QED

La QED (Quantum Electrodinamics) constituye la más

simple pero a la vez más exitosa teoría que nos permite aplicar los principios

de la mecánica cuántica y la relatividad especial al electromagnetismo. Para

calcular la energía del vacío en QED debemos cuantizar el campo

electromagnético. Al cuantizar obtenemos la expresión:

Pvac=E/V=1/VSum(1/2hWk)=h/(2pi2c3)§0Wmax(w3)

dW=h/(8pi2c3)w4max

Esta expresión nos conduce a la famosa analogía entre el

campo electromagnético y un oscilador armónico cuántico. De esta forma la

energía del punto cero será la suma de la energía del punto cero de cada

oscilador armónico.

Wmax es un parámetro denominado frecuencia de corte que

hablando “a grosso modo” es el valor a partir del cual la contribución de los

armónicos de alta frecuencia se considera despreciable. El valor a introducir

en Wmax es objeto de discusión y la estimación de Pvac depende del valor

elegido. Un valor razonable para Wmax sería aquel en el que el

electromagnetismo deja de existir como tal y se unifica con la fuerza débil, es

decir, la energía a la que se restablece la simetría electrodébil que es del

orden de 100GeV. Con este valor obtenemos:

Pvac=(100GeV)4=1046 erg/cm3 (55

órdenes mayor que el valor experimental).

El cálculo de la energía del vacío electrodébil

En la teoría electrodébil, la energía que adquieren

las partículas y los campos cuánticos al romperse la simetría es proporcional

al vacío del campo de Higgs. El potencial del Higgs es:

V(Ø)=Vo-µ2Ø2+gØ4.

Donde g es la constante de autoacoplamiento del Higgs.

Este potencial es mínimo para

Ø2= µ2/2g por tanto V(Ø)=Vo-µ4/4g

Considerando que V(Ø) se anula para Ø=0 tenemos:

Pvac=-µ4/4g=-gv4=-(105GeV)4= -1043 erg/cm3 (52

órdenes de mayor que el valor experimental)

El cálculo de la energía del vacío de la QCD

La QCD (Quantum Chromodynamics) es la teoría cuántica

que se utiliza cuando tenemos en cuenta la fuerza nuclear fuerte, es decir,

cuando estudiamos el interior del núcleo atómico. En QCD existe una escala de

energía característica denominada Lqcd que es la escala a la cual se restablece

la simetría quiral y desaparece el condensado quark-gluon del vacío cuántico;

por esto la energía del vacío en QCD se suele considerar un prefactor de Lqcd.

El cálculo estimativo nos dice entonces que

Pvac=(10-3 o 10-2)4= 1035 o

1036 erg/cm3 (44 o 45 órdenes mayor que el

valor experimental)

El cálculo de la constante cosmológica según la

Relatividad General

Si consideramos la gravedad el problema se vuelve aún

más difícil, algunos dirían que casi imposible de resolver. El campo

gravitatorio "crea" partículas de forma equivalente a un marco de

referencia acelerado. El efecto Unruh se basa en este fenómeno, de forma que un

detector acelerando en un espacio vacío detectará partículas continuamente. Sin

embargo, existe una buena noticia: los experimentos nos indican que cuando la

gravedad es débil, por ejemplo en la Tierra, los cálculos de nuestras teorías

cuánticas son correctos y por lo tanto podemos despreciar las contribuciones de

la gravedad a la energía del vacío.

Posibles soluciones al problema

Como hemos visto, las contribuciones de los campos

conocidos a la energía del vacío son enormes, muchos órdenes de magnitud por

encima del valor observado experimentalmente. A continuación se enumeran 4

posibles soluciones al que es considerado por muchos como el mayor problema de

la Física:

1º) La existencia de nuevos campos y

partículas que cancelen el enorme exceso de energía estimado

Muchos físicos piensan que tienen que existir nuevas

partículas y nuevos campos cuánticos por encima del rango de energías explorado

que contribuirían a la energía del vacío con signo contrario y que podrían

cancelar la inmensa densidad de energía que predicen nuestras teorías. La

supersimetría es uno de los candidatos favoritos, sin embargo, debido a que la

supersimetría está rota a bajas energías esta cancelación no sería ni mucho

menos exacta, por lo que el problema persiste. El problema es que es muy

difícil que un modelo teórico pueda producir un ajuste tan inmensamente preciso

como el requerido. ¡El ajuste tendría que cancelar el exceso con una exactitud

de al menos 56 cifras decimales!

2º) Realizar una modificación de nuestras

teorías cuánticas

Nadie sabe cómo realizar esto, además éstas han tenido

un éxito experimental sin precedentes.

3º) Realizar una modificación de la relatividad

general

Esto tiene el mismo inconveniente que la anterior.

4º) Considerar que el vacío no posee ninguna

densidad de energía

Esta solución parece imposible, sin embargo, merece tenerse

en consideración: no existe ningún experimento cuántico que pueda medir esta

energía puesto que siempre medimos diferencias de energía.

Además todos los experimentos considerados como debidos a la energía del vacío

(efecto Cassimir, desplazamiento Lamb del átomo de hidrógeno, etc) pueden

explicarse como fluctuaciones de los objetos materiales del experimento (ver

por ejemplo Schwinger Source Theory). Considerar que el vacío

es el estado con 0 energía y 0 momento resolvería de un plumazo el problema de

la constante cosmológica cuyo valor es casi nulo. Por supuesto habría que

estudiar las posibles implicaciones de imponer tal condición en las teorías

actuales.

Si esto resultara correcto el vacío sería la primera

entidad física conocida que no posee energía ni momento y por tanto se podría

"crear" en infinita cantidad sin un aporte neto de energía ¿Como

sucedió en la inflación cósmica?

Anexo 9. Ecuación de la Relatividad General de

Einstein

La Catástrofe del Vacío:

https://es.resonancescience.org/blog/la-catastrofe-del-vacio-2

En términos técnicos, las ecuaciones de campo de Einstein

son un conjunto de ecuaciones (concretamente, ecuaciones diferenciales

parciales no lineales) que pueden expresarse de forma sintetizada como una

única ecuación:

donde el primer subíndice μ (mu en griego) representa las coordenadas del espaciotiempo y el segundo subíndice ν (nu en griego) representa las coordenadas del momento (es decir, el cambio de las coordenadas del espacio-tiempo -en términos simples, la posición- con respecto al tiempo). G es la constante gravitacional, c es la velocidad de la luz, Rμν se llama tensor de curvatura de Ricci, gμν se llama tensor métrico, es la curvatura escalar y Tμν se llama tensor de tensión-energía. Esta ecuación incluye la constante Λ, conocida como la constante cosmológica, para dar cuenta de una fuente adicional de energía. Λ representa una fuerza adicional de expansión (energía oscura). La figura un poco más abajo muestra los términos de la ecuación anterior y su significado.

La existencia de la energía y la materia oscuras se dedujeron para que las ecuaciones de campo de Einstein pudieran predecir correctamente la expansión del universo y la velocidad de rotación de las galaxias. Según este punto de vista, la energía oscura es la fuente de una fuerza de expansión en el universo (es lo que explica la constante de Hubble en las principales teorías), mientras que la materia oscura proporciona una fuente de gravedad adicional necesaria para estabilizar las galaxias y los cúmulos de galaxias, ya que no hay suficiente masa ordinaria para mantenerlos unidos dada la expansión acelerada del Universo. Esta gravedad adicional también explicaría la velocidad rotacional de las galaxias.

A grandes rasgos, el lado izquierdo de la ecuación de la

figura anterior expresa la deformación geométrica del espacio-tiempo producida

por la contribución de energía-masa en el lado derecho de la misma ecuación.

Esta deformación del espacio también explica las ondas gravitacionales

detectadas recientemente por LIGO en 2015 y que emanan de la fusión de dos

agujeros negros.

Como afirma el físico John Wheeler, "el espacio-tiempo

le dice a la materia cómo moverse; la materia le dice al espacio-tiempo cómo

curvarse".

Anexo 10. Ecuación de Dirac

https://significado.com/ecuacion-de-dirac/

Aplicar reglas de cuantización sobre una función

vectorial de cuatro dimensiones

Las reglas de cuantización conducen a operaciones con

derivadas que normalmente actúan sobre una función de onda escalar, pero como

las constantes α y β son matrices de 4X4, los operadores diferenciales actuarán

sobre un vector de cuatro dimensiones Ψ, al que luego se le llamó el espinor.

Si se elige un sistema de medida en el que la velocidad de la luz sea 1, la ecuación de Dirac se escribe así:

En la ecuación anterior se expresa una sumatoria sobre los índices μ, comenzando desde 0 hasta 3, y por supuesto, “i” es la unidad imaginaria, ya que se trata de una ecuación en variable compleja.

Esta ecuación se suele compactar más mediante el uso del

símbolo ∂ atravesado por una barra inclinada / para simbolizar la sumatoria de

derivadas, así queda:

Esa expresión es la

que ha quedado como “ecuación del amor”.

Las soluciones de la ecuación de Dirac y el espín del

electrón

La ecuación de Dirac es una ecuación de autovalores que

corresponden a las energías posibles. Hay dos soluciones con energía positiva,

una para cada estado de espín, y dos soluciones con energía negativa, también

para cada uno de los dos estados posibles de espín.

Es de resaltar que el espín, en la ecuación de Dirac,

aparece naturalmente, como un resultado de sus posibles soluciones y a

consecuencia directa de tomar en cuenta la energía relativista.

Es así que, por primera vez en la Física, se cae en cuenta

que el espín, una propiedad intrínseca del electrón y de otras partículas

elementales, es una consecuencia de la relatividad. Por cierto, esta propiedad

del electrón había sido comprobada antes que Dirac formulara su ecuación,

gracias al famoso experimento de Stern y Gerlach en 1922.

La ecuación de Dirac predice la existencia de la

antimateria

Dirac fue increíblemente brillante al haber obtenido su

ecuación, aplicando ingeniosamente las matemáticas, y también es notable la

forma en que interpretó sus soluciones.

Al principio, a Dirac no le quedaba claro si había

electrones con energía cinética negativa. Entonces teorizó lo siguiente:

El vacío (la ausencia de electrones) no es tal, sino que

está lleno de electrones con energía negativa en sus dos estados de espín.

Lo que sucede es que los científicos no tienen la

posibilidad de ver esos electrones, de la misma forma que normalmente no se ven

los peces del mar, de allí sale la denominación mar de Dirac.

Ahora bien, si un fotón es capaz de entregar energía suficiente

a uno de los electrones de ese mar, entonces sí será visible, apareciendo de la

nada.

Pero el espacio vacante en el mar de Dirac es un hueco de

carga positiva, es decir una partícula de la misma masa y carga que el

electrón, pero positiva, llamada positrón.

Poco tiempo después de la interpretación de Dirac, en 1932,

Carl D. Anderson detectó experimentalmente el positrón.

Anexo 11. Métrica de Alcubierre

Métrica de Alcubierre:

https://es.wikipedia.org/wiki/M%C3%A9trica_de_Alcubierre

Gráfico de la impulsión de Alcubierre, mostrando las

regiones opuestas, contraída y extendida, del espacio-tiempo respecto al sector

central en el cual se ubica la burbuja plana de deformación.

La Métrica de Alcubierre es una idea